生成AIを“神格化”するのは、もうやめよう。―それは「新しい宗教」じゃなくて、ただの“道具”だ。

生成AIが話題になるたびに、空気が少し変になる。

「これで仕事は消える」

「人間より賢い」

「もう全部AIがやる時代だ」

もちろん、気持ちは分かる。

実際、生成AIは目に見えて“成果”を出す。文章が書ける。要約できる。企画も出せる。コードも書ける。しかも速い。

でも、ここで一度、冷静になった方がいい。

生成AIを“神格化”した瞬間、プロジェクトは失敗しやすくなる。

そして、現場が疲弊する。

技術はだいたい「名前を変えて」再登場する

これまでのITの歴史は、わりとシンプルだ。

- ASP が SaaS になった

- データセンター が クラウド になった

- 検索 が ナレッジ活用 になった

- RPA が 自動化プラットフォーム になった(言い方だけ豪華になる)

やっていることの“芯”が、いきなり別物になったわけではない。

技術は少しずつ改善され、提供形態が整い、使う側のハードルが下がった。結果として「使われるようになった」。

つまり多くの場合、“革命”というより 普及のタイミング だ。

生成AIもここに近い。

急に世界が変わったというより、「使える状態になって、誰でも触れるようになった」。

生成AIの正体は「すごい言葉のエンジン」だ

生成AIは、確かにすごい。

でも“すごさ”の中身を誤解すると危険になる。

生成AIがやっているのは、ざっくり言うとこういうことだ。

- 過去に学習した膨大な文章パターンから

- 「この文脈なら次に来る言葉はこれっぽい」を

- 高速に選び続ける

だから、文章としてはそれっぽくまとまる。

提案書っぽいものも出せる。論理っぽく見せるのも得意。

ただし、ここに落とし穴がある。

生成AIは「分かっているように見える」だけで、保証はしない

- 正しいかどうかは別

- 事実確認は別

- 現場固有の事情は別

- 責任は取らない

この「それっぽさ」と「正しさ」を混同した瞬間に、事故が起きる。

神格化が始まると、よくある失敗パターンに入る

生成AI導入でよく起きる失敗は、技術の問題ではない。

期待の置き方の問題だ。

失敗パターン1:AIに“判断”までさせようとする

生成AIに任せるべきは、基本的に「作業」や「整理」だ。

でも導入側が盛り上がると、すぐにこうなる。

- 見積の妥当性判断までAIに

- 契約書のリスク判断までAIに

- 社内ルールの例外処理までAIに

- 現場の“暗黙”を読み取らせようとする

ここは人間の仕事が残る。というより、残って当然。

判断は「責任」とセットだからだ。

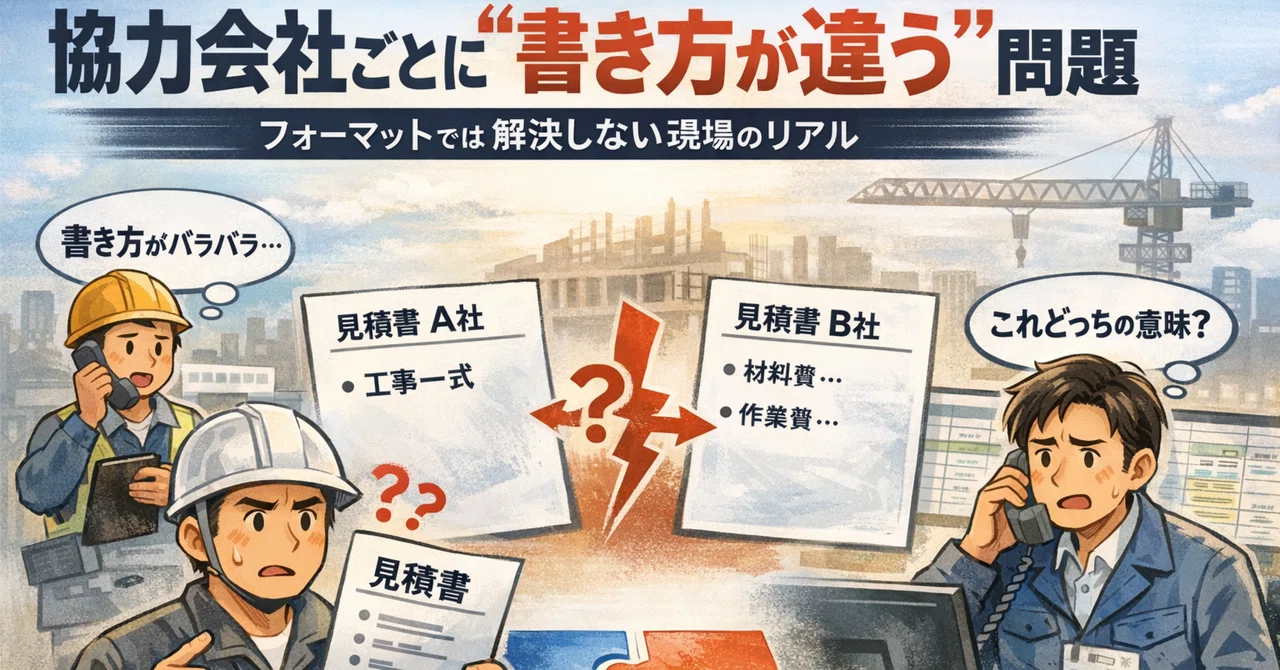

失敗パターン2:入力が雑でも“AIなら何とかする”と思う

生成AIは“雑な入力”にも付き合ってくれる。

でもそれは「解けた」ではなく、「それっぽく答えた」だけのことが多い。

- ルールが曖昧

- 前提が不足

- 用語が統一されていない

- データが欠落している

こういう状態で「AIに投げれば何とかなる」と期待すると、

結果はだいたい「出力の信頼性が揺れる」→「現場が使わない」になる。

失敗パターン3:成功の定義がない

生成AIプロジェクトは、PoCで盛り上がりやすい。

デモが映えるから。

でも、成功の定義が曖昧だとこうなる。

- “便利”だけど定着しない

- “それっぽい”けど使われない

- “人が直す手間”が残って結局コスト増

重要なのは「出力」ではなく、運用まで含めた成果だ。

じゃあ生成AIは何が得意なのか?(現場目線)

神格化をやめると、生成AIはめちゃくちゃ強い道具になる。

得意な領域は明確だ。

1)文章・情報の「整形」「要約」「構造化」

- 議事録を要点に整理する

- 長文メールを短くする

- 仕様書の論点を抜き出す

- 複数資料を比べて差分を言語化する

これだけでも現場の時間はかなり削れる。

2)“たたき台”の高速生成

- 提案書の骨子

- 企画の案出し

- 仕様の叩き

- FAQの初稿

ポイントは「最初から完成品を求めない」こと。

たたき台として使うと最高に速い。

3)人が判断するための「材料集め」

生成AIは判断の代替ではなく、判断の前の準備を爆速にする。

- 情報を集める

- 論点を整理する

- 選択肢を並べる

- リスク観点を列挙する

最後に判断するのは人間。

でもその前段はAIが肩代わりできる。

「ASP→SaaS」「データセンター→クラウド」と同じ話

ここで最初の話に戻る。

ASPもクラウドも、登場初期は誤解されていた。

- “入れれば業務が勝手に良くなる”と思われた

- “導入すれば生産性が上がる”と思われた

- “人がいらなくなる”みたいに語られた

現実は違った。

業務が良くなるのは、

設計が変わった時であり、

運用が回る状態を作った時だ。

生成AIも同じ。

入れただけでは何も変わらない。

生成AI導入で本当に大事なことは「境界線」だ

結局、成果が出るかどうかはここに尽きる。

AIに任せるべき領域

- 反復

- 整形

- 要約

- 検索

- たたき台

- 事務的な判断(ルールが明確)

人が担うべき領域

- 例外処理

- 現場の文脈理解

- リスク判断

- 最終責任

- 会社固有のルール(暗黙知)

そして現実には、この境界線のところに一番コストがある。

「ルールが曖昧」「例外が多い」「判断が属人」の場所だ。

だからこそ、生成AIの価値は「判断の再現」に向かう

生成AIは万能ではない。

でも、現場の一番しんどい場所に近づける方法がある。

それは、

- 人の判断をログとして残し

- 判断の前提・条件を整理し

- 例外を分類し

- “再現できる形”にする

こうして初めて、AIが“運用に耐える”領域が広がる。

つまり、生成AIの未来は「全部置き換える」ではなく、

判断を再現できる範囲を少しずつ増やすことにある。

神格化をやめた瞬間、生成AIは最強の道具になる

生成AIは革命ではない。

正確には、「革命として語りたくなるほど便利な道具」だ。

- 魔法ではない

- 神ではない

- でも、使い方次第で現場の時間を取り戻せる

神格化をやめよう。

代わりに、境界線を引こう。

「どこまでAIに任せるのか」

「どこから人が責任を持つのか」

それを整理した会社だけが、生成AIを武器にできる。

Connected Baseのご紹介

「AI-OCR」「RPA」から

“LLM+人の判断”の再現へと移りつつあります。

Connected Base は、日々の見積書・請求書・報告書など、

人の判断を必要とする“あいまいな領域”を自動で処理し、

現場ごとのルールや判断のクセを学習していくAIプラットフォームです。

これまで人が時間をかけて行ってきた仕分けや確認を、

AIとルール設定だけで再現・蓄積・自動化。

単なる効率化ではなく、「判断の継承」まで含めたDXを実現します。

現場の知恵を未来につなぐ──

その第一歩を、Connected Baseとともに。